Alors que le monde de la technologie évolue à un rythme effréné, les entreprises se tournent de plus en plus vers des architectures modernes pour gérer efficacement les flux de données. L’architecture orientée événements, et plus particulièrement l’event sourcing, représente une réponse aux besoins croissants en matière de flexibilité et d’évolutivité. Associé à des outils performants comme Apache Kafka, l’event sourcing permet de capitaliser sur chaque changement d’état au sein d’une application. Cependant, intégrer cette approche dans son système n’est pas sans défis. Cet article explore les principales difficultés rencontrées dans la mise en œuvre de l’event sourcing avec Kafka, ainsi que des stratégies pratiques pour les surmonter efficacement.

Les fondamentaux de l’Event Sourcing avec Kafka

L’event sourcing est une méthode qui repose sur l’enregistrement de chaque changement d’état d’une application sous forme d’événements. Contrairement aux bases de données traditionnelles qui stockent uniquement l’état actuel, l’event sourcing conserve l’historique complet des modifications. Cette technique a gagné en popularité ces dernières années, en particulier avec l’essor d’Apache Kafka, une plateforme de streaming de données en temps réel.

Considérons un système classique où un utilisateur modifie son adresse e-mail. Dans un modèle traditionnel, cette modification remplace l’ancienne valeur. En revanche, dans un système d’event sourcing, un événement intitulé « EmailChanged » est créé, consignant à la fois l’ancienne et la nouvelle adresse e-mail. Cette approche offre plusieurs avantages, notamment :

- Traçabilité : Chaque événement est immuable, ce qui permet de retracer les modifications et d’analyser l’historique des données.

- Résilience : En cas de panne, il est possible de reconstruire l’état à partir des événements enregistrés.

- Interopérabilité : Les systèmes peuvent communiquer grâce à des événements standardisés.

Sur la base de cette méthode, une entreprise fictive, « TechSolutions », utilise l’event sourcing pour gérer les données de ses clients. Grâce à cette stratégie, l’entreprise a optimisé son service client, permettant un accès rapide à l’historique complet des interactions avec chaque utilisateur, ce qui a amélioré la satisfaction client.

Les bénéfices de l’intégration d’Apache Kafka

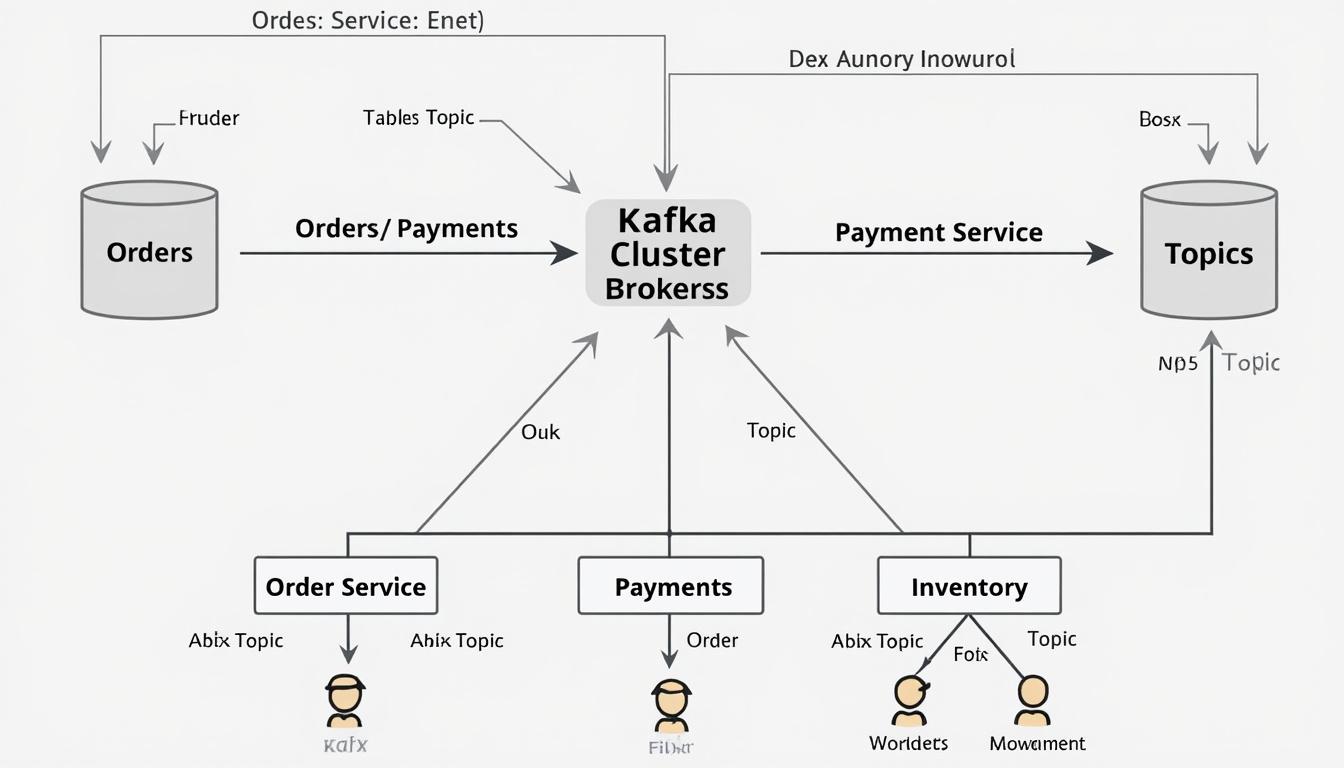

Apache Kafka se distingue comme une plateforme clé pour l’event sourcing en raison de sa capacité à gérer de grands volumes d’événements en temps réel. Son architecture décentralisée permet une scalabilité impressionnante. Voici quelques caractéristiques clés de Kafka qui en font un choix privilégié :

| Caractéristique | Description |

|---|---|

| Durabilité | Les événements sont conservés de manière persistante, garantissant leur disponibilité à long terme. |

| Performance | Kafka peut gérer facilement des millions d’événements par seconde sans perte de performance. |

| Rétention des données | Il permet de choisir la durée pendant laquelle les événements sont conservés. |

La puissance de Kafka est souvent illustrée par le cas de « FoodLog », une entreprise de logistique qui utilise Kafka pour suivre en temps réel les expéditions et les stocks. Grâce à l’event sourcing et à Kafka, FoodLog peut ajuster ses opérations en fonction des fluctuations du marché, améliorant ainsi sa réactivité.

Principaux défis de l’Event Sourcing avec Kafka

Bien que l’event sourcing proposé par Kafka offre de nombreuses opportunités, plusieurs défis doivent être abordés pour garantir un déploiement efficace. L’un des obstacles majeurs est la complexité de la gestion des événements. Lorsqu’une entreprise passe d’une architecture classique à l’event sourcing, elle doit s’assurer que chaque événement est bien défini et que leur ordre d’arrivée est correctement garanti.

La gestion de la complexité des événements

La gestion de la complexité commence par la structuration appropriée des événements. Les entreprises doivent s’assurer que les événements sont conçus de manière modulaire, ce qui facilite leur maintenance et leur évolution. Par ailleurs, la validation des événements joue un rôle essentiel pour préserver l’intégrité des données et éviter des erreurs réseau. Les meilleures pratiques recommandées incluent :

- Développer des règles strictes de validation des événements.

- Utiliser des outils et des frameworks pour automatiser les tests et la validation.

- Intégrer des systèmes de surveillance afin de détecter les problèmes rapidement.

Un exemple concret est celui de « HealthTrack », une solution de télédiagnostic. Cette entreprise a mis en place un système de validation robuste pour s’assurer que chaque événement lié aux données patients respectait des règles de conformité, minimisant ainsi les risques d’erreur.

Les meilleures pratiques pour optimiser l’Event Sourcing

Pour surmonter ces défis, les entreprises doivent adopter certaines meilleures pratiques spécifiques à l’event sourcing. L’efficacité du système dépend souvent de l’intégration des bonnes stratégies dès la phase de conception.

Stratégies à mettre en œuvre

Les entreprises doivent envisager plusieurs approches pour assurer une mise en œuvre réussie :

- Modularité des événements : Concevoir des événements indépendants pour des composants spécifiques du système.

- Utilisation de systèmes de monitoring : Implémenter des outils tels que Prometheus pour avoir une surveillance en temps réel des événements.

- Formation des équipes : Former les équipes de développement aux meilleures pratiques de gestion des événements.

En intégrant ces pratiques, une entreprise comme « RetailPro », spécialisée dans la vente au détail, a bénéficié d’une gestion des données clients beaucoup plus réactive, grâce à des événements bien définis et à des alertes en temps réel.

Les outils et frameworks complémentaires pour maximiser l’Event Sourcing

Au-delà de Kafka, plusieurs outils et frameworks peuvent enrichir les solutions basées sur l’event sourcing. Des solutions comme EventStore, Apache Pulsar, ainsi que Spring Cloud Stream peuvent apporter des fonctionnalités supplémentaires pour optimiser la gestion des événements.

Les outils à considérer

| Outil | Description |

|---|---|

| EventStore | Outil spécialisé pour le stockage d’événements avec des fonctionnalités de recherche avancées. |

| Apache Pulsar | Propose un modèle de publication/abonnement avec une résilience accrue. |

| Spring Cloud Stream | Framework qui facilite la création d’applications basées sur les événements. |

Ces outils, lorsque combinés avec Kafka, permettent de construire une infrastructure de traitement des événements beaucoup plus robuste, capable de s’adapter aux exigences croissantes des entreprises.

Surveillance et maintenance des systèmes d’Event Sourcing

Un des aspects souvent négligés de l’event sourcing est la surveillance continue des systèmes. Il est crucial de suivre l’activité des événements afin d’assurer un fonctionnement optimal. Des outils de monitoring s’avèrent indispensables dans ce contexte.

Éléments de surveillance clés

Les éléments suivants doivent faire l’objet d’une attention particulière :

- Log d’événements : Servent de base pour le dépannage et l’analyse.

- Alertes sur les anomalies : Permettent d’identifier rapidement des problèmes potentiels avant qu’ils n’impactent l’utilisateur.

- Analyse des performances : Mesure le temps de réponse et le traitement des événements.

La mise en place d’une telle surveillance a permis à des entreprises comme « Fintelligence », spécialisée dans les services financiers, de maintenir des niveaux de service exceptionnels en réagissant rapidement aux anomalies détectées.

Comprendre les enjeux de l’Event Sourcing

En adoptant l’event sourcing, les entreprises doivent comprendre les enjeux qui y sont associés. La gestion des événements et le choix des technologies correctes sont essentiels pour obtenir une solution efficace et évolutive. L’approche orientée événements favorise la rapidité dans le développement et le déploiement des solutions en courante.

Les principales questions à se poser

Les entreprises doivent aborder plusieurs questions essentielles lors de l’implémentation de l’event sourcing avec Kafka :

- Comment garantir l’ordre d’arrivée des événements ?

- Quelle stratégie de partitionnement utiliser pour le stockage des données ?

- Quels outils de sécurité et de sauvegarde mettre en place ?

Ces questions permettent de s’assurer que le système mis en place est non seulement performant mais également fiable et durable dans le temps.

FAQ

Qu’est-ce que l’event sourcing ?

L’event sourcing est un modèle qui enregistre tous les changements d’état d’une application sous forme d’événements immuables, permettant de conserver l’historique des modifications.

Pourquoi utiliser Kafka pour l’event sourcing ?

Kafka est une plateforme capable de gérer de grands volumes d’événements en temps réel, garantissant une distribution fiable et une scalabilité exceptionnelle.

Quels outils peuvent compléter l’event sourcing avec Kafka ?

Outre Kafka, des outils comme EventStore, Apache Pulsar et Spring Cloud Stream renforcent la gestion des événements dans les architectures modernes.

Quels sont les principaux défis de l’event sourcing ?

Les défis incluent la complexité de la gestion des événements, la garantie d’ordre, et la nécessité d’une surveillance rigoureuse.

Comment garantir la performance d’un système événementiel ?

Il est nécessaire de suivre des meilleures pratiques, telles que la modularité des événements, la mise en place d’alertes, et l’utilisation de systèmes de monitoring pour assurer une performance optimale.